引言

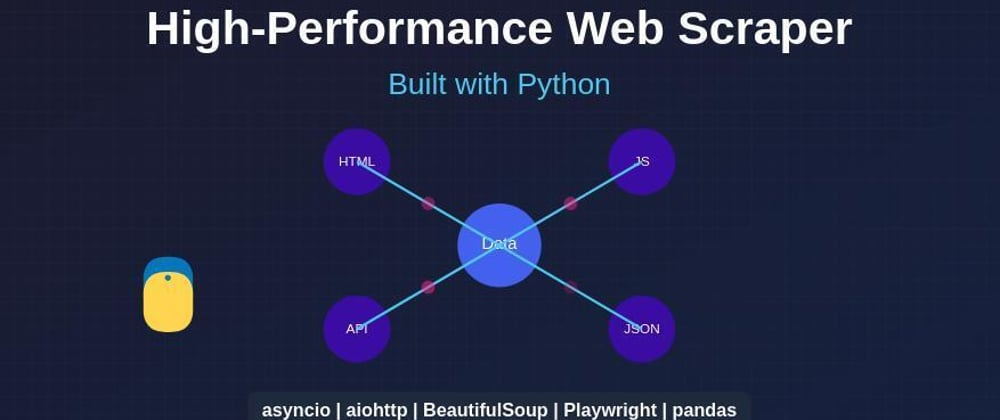

本文探讨了一种高性能网页爬虫的架构和实现,该爬虫旨在从电子商务平台提取产品数据。该爬虫使用多个Python库和技术,以高效处理数千个产品,同时保持对常见爬取挑战的韧性。

技术架构

该爬虫建立在完全异步的基础上,使用Python的 asyncio 生态系统,包含以下关键组件:

- 网络层:

aiohttp用于异步HTTP请求,支持连接池 - DOM处理:

BeautifulSoup4用于HTML解析 - 动态内容:

Playwright用于提取JavaScript渲染的内容 - 数据处理:

pandas用于数据操作和导出

实现亮点

并发管理

该爬虫实现了一个工作池模式,具有可配置的并发限制:

# 并发设置

self.max_workers = int(os.getenv('MAX_WORKERS'))

self.max_connections = int(os.getenv('MAX_CONNECTIONS'))

# TCP 连接池

connector = aiohttp.TCPConnector(

limit=self.max_connections,

resolver=resolver # 自定义 DNS 解析器

)

这可以防止对目标服务器造成过大的压力,同时最大化吞吐量。弹性网络请求

网络层实现了复杂的重试逻辑,并采用指数退避策略:

async def fetch_url(self, session, url):

retries = 0

while retries < self.max_retries:

try:

headers = {

'User-Agent': self.user_agent.random,

# 为了简洁省略了其他头部信息

}

async with session.get(url, headers=headers, timeout=self.request_timeout) as response:

if response.status == 200:

return await response.read()

elif response.status == 429:

# 速率限制处理

retry_after = int(response.headers.get('Retry-After',

self.retry_backoff ** (retries + 2)))

await asyncio.sleep(retry_after)

# 使用指数退避重试

retries += 1

wait_time = self.retry_backoff ** (retries + 1)

await asyncio.sleep(wait_time)

except (asyncio.TimeoutError, aiohttp.ClientError) as e:

logger.warning(f"网络错误: {e}")

retries += 1

混合内容提取该爬虫采用两阶段提取方法:

- 静态HTML解析:使用BeautifulSoup提取现成的内容

- 动态内容提取: 使用 Playwright 处理 JavaScript 渲染的元素

async def fetch_product(self, session, url, page):

# 静态内容提取

with concurrent.futures.ThreadPoolExecutor() as executor:

loop = asyncio.get_event_loop()

product = await loop.run_in_executor(

executor,

partial(self.scrape_product_html, content, url)

)

# 动态内容提取

image_url, description = await self.scrape_dynamic_content_playwright(page, url)

product.image_url = image_url

product.description = description

这种方法在速度和完整性之间进行了优化。DNS 弹性

爬虫实现了 DNS 回退机制,以处理潜在的 DNS 解析问题:

try:

import aiodns

resolver = aiohttp.AsyncResolver(nameservers=["8.8.8.8", "1.1.1.1"])

except ImportError:

logger.warning("未找到 aiodns 库。将回退到默认解析器。")

resolver = None

数据处理管道

爬虫实现了一个线程安全的队列来处理抓取的数据:

# 结果的线程安全队列

self.results_queue = queue.Queue()

# 数据处理

def save_results_from_queue(self):

products = []

while not self.results_queue.empty():

try:

products.append(self.results_queue.get_nowait())

except queue.Empty:

break

if products:

df = pd.DataFrame(products)

# 以正确的编码和转义保存为CSV文件

df.to_csv(

filename,

index=False,

encoding='utf-8-sig',

escapechar='\\',

quoting=csv.QUOTE_ALL

)

性能优化

采用多种技术来最大化吞吐量:

- 批处理:产品以可配置的批次进行处理

- 随机延迟:请求之间的随机延迟防止被检测

- 连接池:TCP连接重用减少开销

- 线程池执行器:将CPU密集型任务卸载,以防阻塞事件循环

- 抽样:对于大型数据集,使用统计抽样来估算总计数

错误处理与可靠性

抓取程序实现了全面的错误处理:

try:

# 抓取逻辑

except Exception as e:

logger.error(f"在 scrape_all_products 中发生错误: {e}")

# 在退出之前保存队列中的任何结果

self.save_results_from_queue()

raise

这确保了即使爬虫崩溃,部分结果也会被保存。

结论

这里概述的架构展示了如何构建一个高性能的网络爬虫,能够在速度、可靠性和对目标服务器的礼貌之间取得平衡。通过利用异步编程、连接池和混合内容提取技术,爬虫能够高效处理数千个产品,同时保持对常见爬取挑战的韧性。

关键要点:

- 异步编程对于高性能网络爬虫至关重要

- 混合静态/动态提取最大化数据完整性

- 适当的错误处理和韧性机制对于生产环境至关重要

- 可配置参数允许根据目标网站特性进行微调